Large Language Models

Die Geburt von ChatGPT

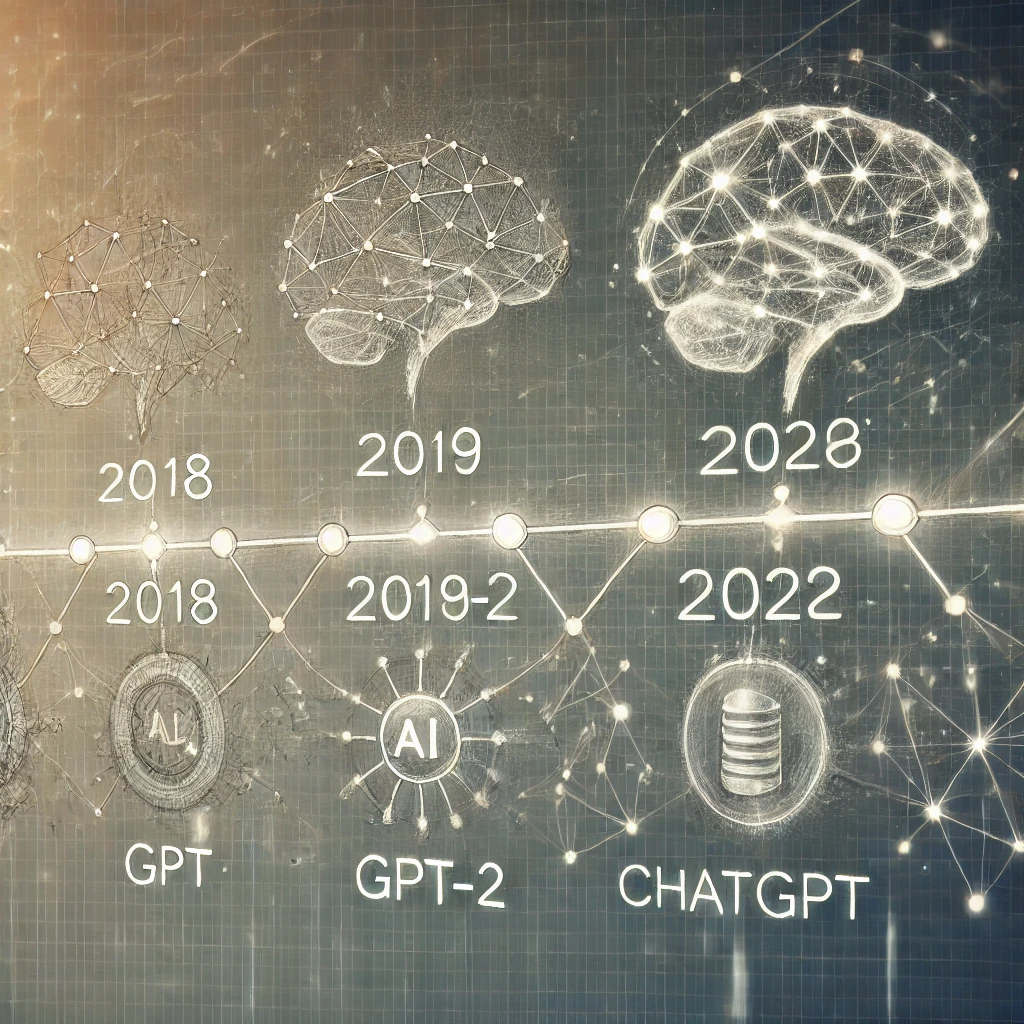

ChatGPT wurde auf Basis von GPT-3 entwickelt und fokussierte sich auf interaktive, konversationsbasierte Anwendungen. Ziel war es, eine natürlichere und nützlichere Kommunikation zwischen Mensch und Maschine zu schaffen. Bereits die Vorgängermodelle GPT und GPT-2 legten den Grundstein für diese Entwicklung. GPT ermöglichte erste Fortschritte in der Verarbeitung natürlicher Sprache, während GPT-2 die Fähigkeit zur Erstellung komplexer und kontextbezogener Texte verbesserte. Durch ständige Optimierungen in den Bereichen Benutzerfreundlichkeit und Sicherheit entwickelte sich ChatGPT zu einem vielseitigen Werkzeug, das in Bildung, Forschung und Wirtschaft eingesetzt wird.

Meilensteine

| Datum | Ereignis |

|---|---|

| Juni 2018 | GPT (Generative Pre-trained Transformer) |

| Februar 2019 | GPT-2 |

| Juni 2020 | GPT-3 wird veröffentlicht und setzt neue Maßstäbe in der KI |

| November 2022 | ChatGPT wird auf Basis von GPT-3 entwickelt und optimiert |

| März 2023 | Veröffentlichung der API für GPT-3.5 und GPT-4 |

| Mai 2023 | Neues Preismodell für die Nutzung der OpenAI-Dienste |

| Juli 2021 | GitHub Copilot |

| Februar 2023 | Claude Sonnet |

| November 2023 | Amazon Q |

Funktionsweise von LLMs

Large Language Models (LLMs) wie ChatGPT beruhen auf neuronalen Netzwerken, insbesondere auf Transformer-Architekturen. Diese Modelle analysieren große Textmengen und lernen dabei Muster, Bedeutungen und Zusammenhänge zwischen Wörtern. Ein zentraler Mechanismus ist die Selbstaufmerksamkeit (Self-Attention), die es dem Modell ermöglicht, relevante Kontextinformationen zu jedem Wort dynamisch zu berücksichtigen.

Ein wichtiger Teil des Trainingsprozesses ist das Reinforcement Learning (verstärkendes Lernen), speziell Reinforcement Learning with Human Feedback (RLHF). Dabei bewerten Menschen die Antworten des Modells und trainieren ein Belohnungsmodell, das die Qualität der Antworten bewertet. Dieses Belohnungsmodell optimiert das Verhalten des Modells während des Trainings und sorgt dafür, dass die generierten Antworten besser an menschliche Erwartungen angepasst werden.

Anfänge

OpenAI begann seine Arbeit an generativen Sprachmodellen im Jahr 2018 mit der Veröffentlichung von GPT. Dieses Modell legte den Grundstein für die KI-gesteuerte Sprachverarbeitung, indem es riesige Datenmengen analysierte, um natürliche Sprache zu verstehen und zu generieren. Die erste Version war ein wichtiger Schritt, aber noch weit von der heutigen Komplexität entfernt.

Fortschritte mit GPT-2 und GPT-3

Ein Jahr später präsentierte OpenAI GPT-2, das aufgrund seiner erweiterten Kapazitäten überzeugte. Es konnte komplexere Texte verfassen und besser auf Kontexte eingehen. 2020 folgte GPT-3, ein Meilenstein in der KI-Entwicklung. Mit 175 Milliarden Parametern wurde GPT-3 zu einem der leistungsstärksten Sprachmodelle und ermöglichte eine Vielzahl an Anwendungen, von Textgenerierung bis hin zu Code-Erstellung.